一、基本概念

(一)、docker-swarm是解决多主机多个容器调度部署得问题。

Swarm是Docker 引擎内置(原生)的集群管理和编排工具。Docker Swarm是 Docker 官方三剑客项目之一,swarm是基于docker平台实现的集群技术,他可以通过几条简单的指令快速的创建一个docker集群,接着在集群的共享网络上部署应用,最终实现分布式的服务。

(二)、Docker swarm中有三种角色:

注:

Swarm: 作用运行docker engin(引擎)的多个主机组成的集群。

node: 每一个docker engin都是一个node(节点),分为 manager 和worker。

- manager node: 负责执行容器的编排和集群的管理工作,保持并维护swarm处于期望的状态。swarm可以有多个manager node,他们会自动协调并选举出一个Leader执行编排任务。但相反,不能没有managernode。

- worker node: 接受并执行由manager node 派发的任务,并且默认manager node也是一个work node,不过可以将它设置为manager-onlynode.让它只负责编排和管理工作。

- service: 用来定义worker上执行的命令。

(三)、Swarm命令行说明:

docker swarm:集群管理

init #初始化集群

join #将节点加入集群

join-token #管理加入令牌

leave #从集群中删除某个节点,强制删除加参数–force

update #更新集群

unlock #解锁集群

docker node:节点管理,

demote #将集群中一个或多个节点降级

inspect #显示一个或多个节点的详细信息

ls #列出集群中的节点

promote #将一个或多个节点提升为管理节点

rm #从集群中删除停止的节点,–force强制删除参数

ps #列出一个或多个节点上运行的任务

update #更新节点

docker service:服务管理,

create #创建一个新的服务

inspect #列出一个或多个服务的详细信息

ps #列出一个或多个服务中的任务信息

ls #列出服务

rm #删除一个或多个服务

scale #扩展一个或多个服务

update #更新服务

二、实验环境

| 系统版本 | 主机名 | IP地址 |

|---|---|---|

| Centos7.7 | node-1 | 10.130.77.28 |

| --------- | node-2 | 10.130.77.31 |

| --------- | node-3 | 10.130.77.36 |

注意事项:

- 实验环境关闭防火墙、禁用selinux、

- 三台dockerhost区别主机名、

- 时间要与本机同步

*管理节点的IP地址

所有swarm集群中的节点都会连接到管理节点的IP地址

主机间开放端口

*以下端口必须是开放的:

TCP port 2377为集群管理通信

TCP and UDP port 7946 为节点间通信

UDP port 4789 为网络间流量

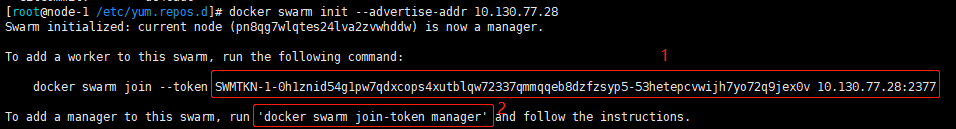

1)初始化swarm集群

[root@node-1 ~]# docker swarm init --advertise-addr 10.130.77.28

注:以上图片中命令释义:

①的命令:以worker身份加入swarm群集中的命令;

②的命令:以manager身份加入swarm群集中的方法;

出现上图表示初始化成功!注意:–token表示期限为24小时;

2)配置node02、node03加入swarm群集

node-2的操作如下:

[root@node-2 ~]# docker swarm join --token SWMTKN-1-0h1znid54g1pw7qdxcops4xutblqw72337qmmqqeb8dzfzsyp5-53hetepcvwijh7yo72q9jex0v 10.130.77.28:2377

node-3的操作如下:

[root@node-3 ~]# docker swarm join --token SWMTKN-1-0h1znid54g1pw7qdxcops4xutblqw72337qmmqqeb8dzfzsyp5-53hetepcvwijh7yo72q9jex0v 10.130.77.28:2377

//以上node02、node03默认是以worker身份加入的

[root@node-1 ~]# docker node ls

ID HOSTNAME STATUS AVAILABILITY MANAGER STATUS ENGINE VERSION

pn8qg7wlqtes24lva2zvwhddw * node-1 Ready Active Leader 20.10.10

w8qk6kotlckaymlxt9ndl439k node-2 Ready Active 20.10.10

xq9ex86y5olcieqesig0k2wvr node-3 Ready Active 20.10.10

//返回node1可以看见加入集群的主机

//查看节点详细信息(只能是manager身份才可查看)

//可以看出node01、node02、node03的状态为Ready

以下命令可以将某一个节点加入、删除集群

[root@node-2 ~]# docker swarm leave

[root@node-3 ~]# docker swarm leave

// docker swarm leave :表示离开集群但是需要manager node的同意

[root@node01 ~]# docker node ls

//这时我们回到node-1上查看加入的两台主机已经Down掉了,但是注意两台主机虽然Down掉了但是任然没有退出集群

[root@node-1 ~]# docker node ls

ID HOSTNAME STATUS AVAILABILITY MANAGER STATUS ENGINE VERSION

pn8qg7wlqtes24lva2zvwhddw * node-1 Ready Active Leader 20.10.10

w8qk6kotlckaymlxt9ndl439k node-2 Down Active 20.10.10

xq9ex86y5olcieqesig0k2wvr node-3 Down Active 20.10.10

[root@node-1 ~]# docker node rm node-2

[root@node-1 ~]# docker node rm node-3

//node01将node-2、node-3移除群集

[root@node-1 ~]# docker node ls

//可以看见只剩node01了

ID HOSTNAME STATUS AVAILABILITY MANAGER STATUS ENGINE VERSION

pn8qg7wlqtes24lva2zvwhddw * node-1 Ready Active Leader 20.10.10

[root@node-1 ~]# docker swarm leave -f

//manager节点退出swamr群集环境,这就表示swarm群集解散

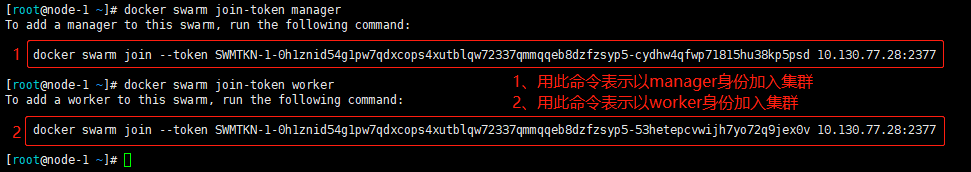

加入时是使用worker身份的,如果想要让节点是以manager身份加入群集,需要使用以下命令:

[root@node-1 ~]# docker swarm join-token manager

//查询以manager身份加入群集的命令

[root@node-1 ~]# docker swarm join-token worker

//查询以worker身份加入群集的命令

[root@node-2 ~]# docker swarm join --token SWMTKN-1-0h1znid54g1pw7qdxcops4xutblqw72337qmmqqeb8dzfzsyp5-cydhw4qfwp71815hu38kp5psd 10.130.77.28:2377

[root@node-3 ~]# docker swarm join --token SWMTKN-1-0h1znid54g1pw7qdxcops4xutblqw72337qmmqqeb8dzfzsyp5-cydhw4qfwp71815hu38kp5psd 10.130.77.28:2377

//以manager身份加入集群

[root@node-1 ~]# docker node ls

ID HOSTNAME STATUS AVAILABILITY MANAGER STATUS ENGINE VERSION

pn8qg7wlqtes24lva2zvwhddw * node-1 Ready Active Leader 20.10.10

lvqee2bhdhrilu8u3nz9oormh node-2 Ready Active Reachable 20.10.10

tdiylqaiztcit1v4qztmgtbwd node-3 Ready Active Reachable 20.10.10

虽然加入群集时,可以指定使用manager、worker身份,但是也可以通过以下命令,进行降级、升级,操作如下:

[root@node-1 ~]# docker node demote node-2

[root@node-1 ~]# docker node demote node-3

//将node02、node03降级为worker

[root@node-1 ~]# docker node promote node-2

[root@node-1 ~]# docker node promote node-3

//将node-2、node-3升级为manager

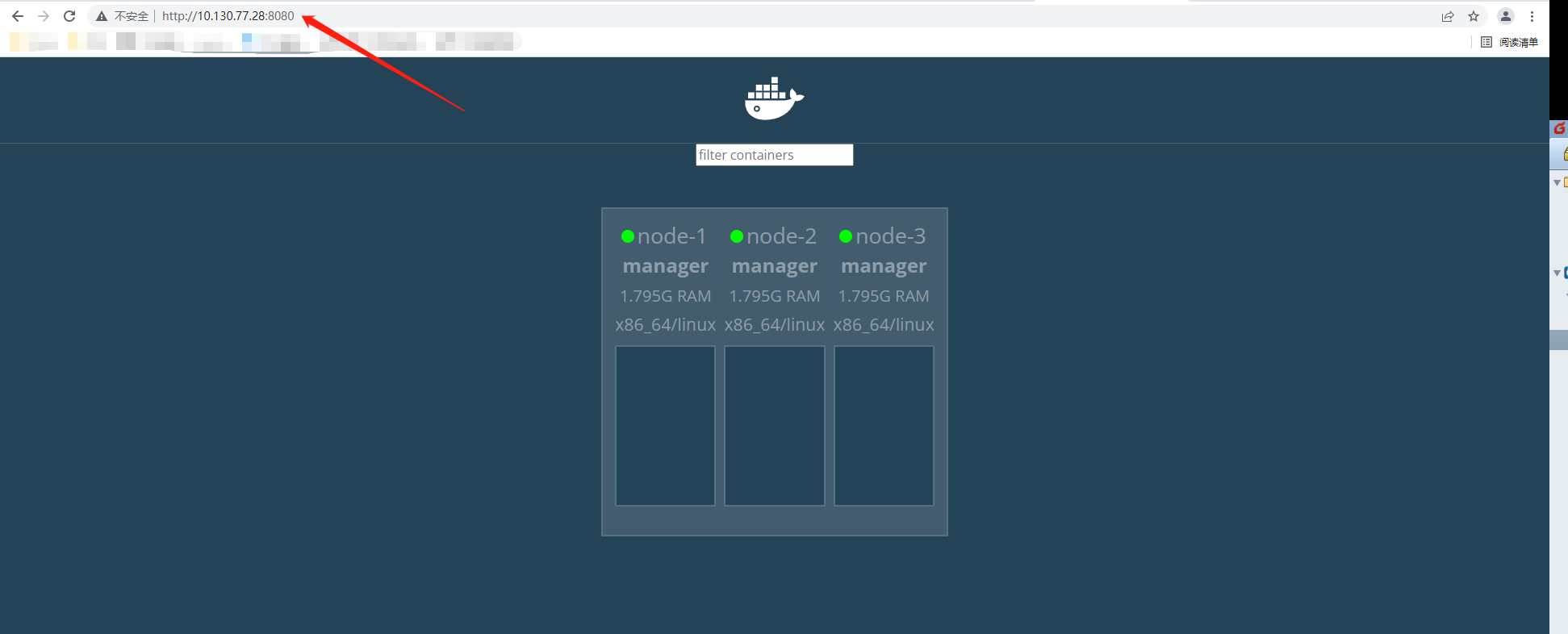

三、部署一个图形化webUI 界面

[root@node-1 ~]# docker run -d -p 8080:8080 -e HOST=172.17.0.10 -e PORT=8080 -v /var/run/docker.sock:/var/run/docker.sock --name visualizer dockersamples/visualizer

通过浏览器访问验证:

//如果访问不到网页,需开启路由转发

[root@node01 ~]#echo net.ipv4.ip_forward = 1 >> /etc/sysctl.conf

[root@node01 ~]# sysctl -p

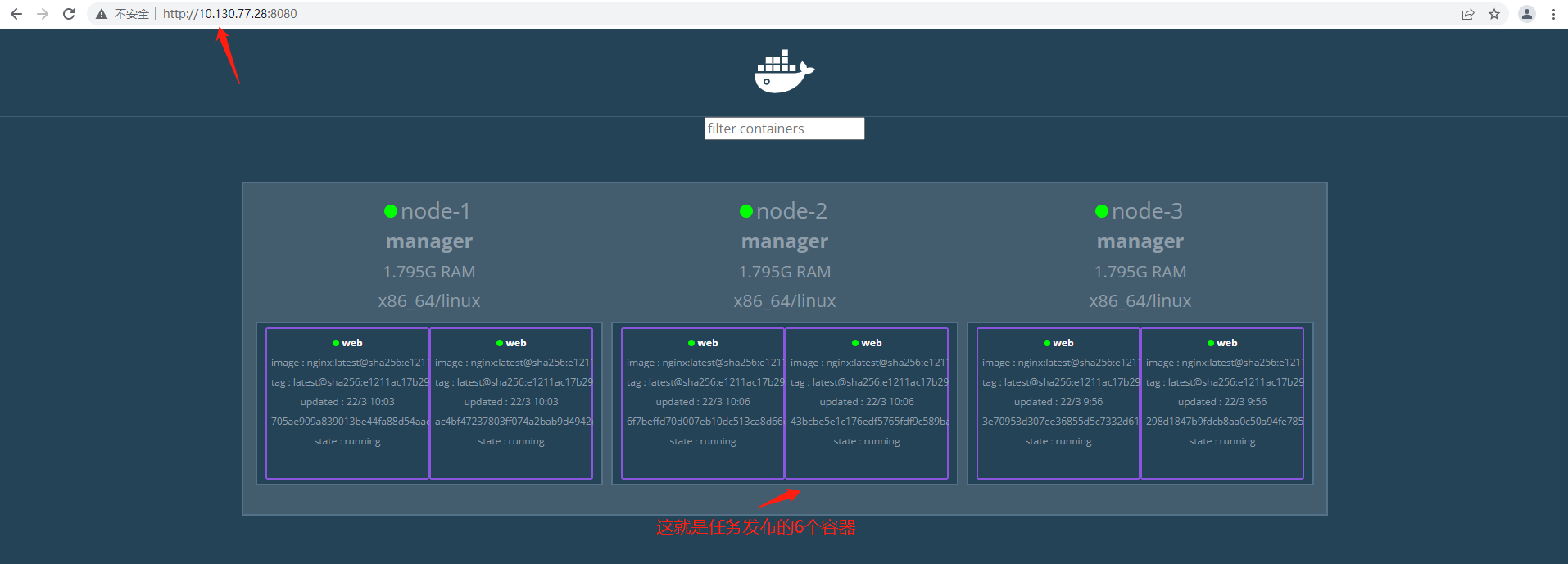

四、docker swarm群集的service服务配置

node01发布一个任务,(必须在manager角色的主机上)运行六个容器,命令如下:

[root@node-1 ~]# docker service create --replicas 6 --name web -p 80:80 nginx

//--replicas: 指定副本数量副本指的也就是容器。

通过浏览器访问验证:

[root@node-1 ~]# docker service ls //查看创建的service

ID NAME MODE REPLICAS IMAGE PORTS

3mhv5tajbu8h web replicated 6/6 nginx:latest *:80->80/tcp

[root@node-1 ~]# docker service ps web //查看创建的service都运行在那些容器上

ID NAME IMAGE NODE DESIRED STATE CURRENT STATE ERROR PORTS

hnox9exrq8zf web.1 nginx:latest node-1 Running Running 9 minutes ago

ydst8flbody7 web.2 nginx:latest node-3 Running Running 16 minutes ago

92c9xkeya53t web.3 nginx:latest node-2 Running Running 6 minutes ago

aq764mfvfkxo web.4 nginx:latest node-1 Running Running 9 minutes ago

3vvdh3yokv1h web.5 nginx:latest node-3 Running Running 16 minutes ago

apy3tut8bph3 web.6 nginx:latest node-2 Running Running 6 minutes ago

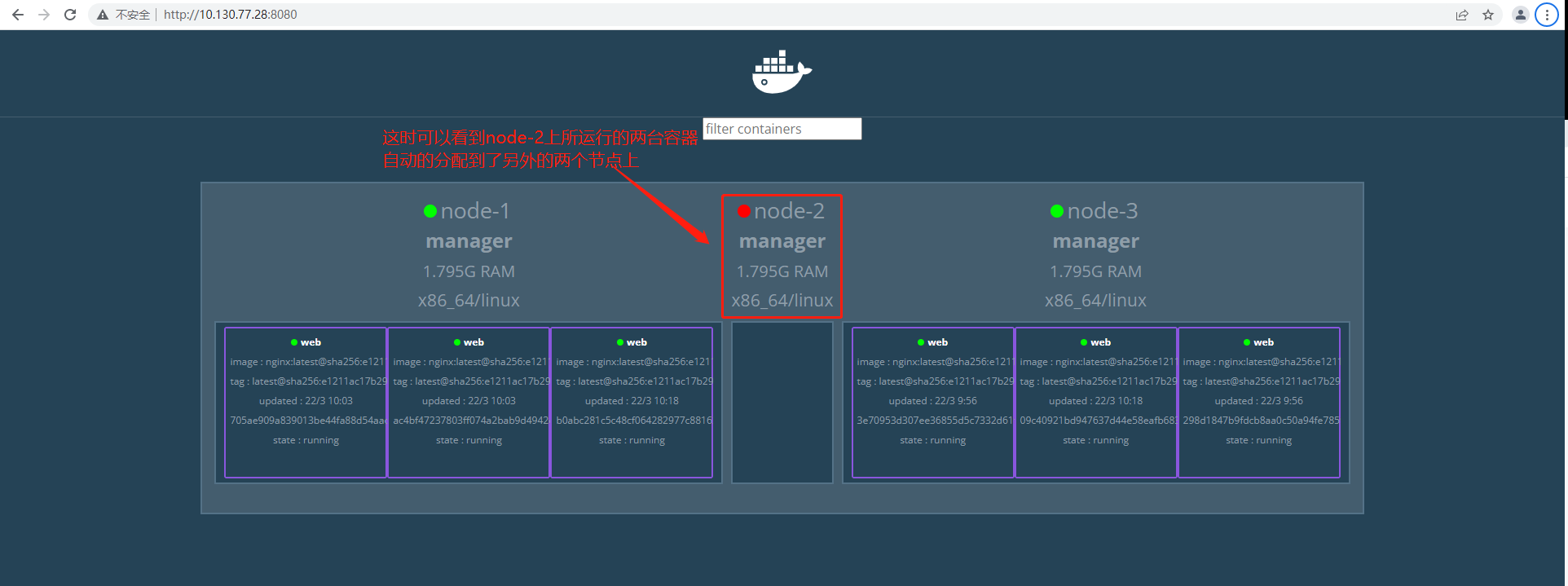

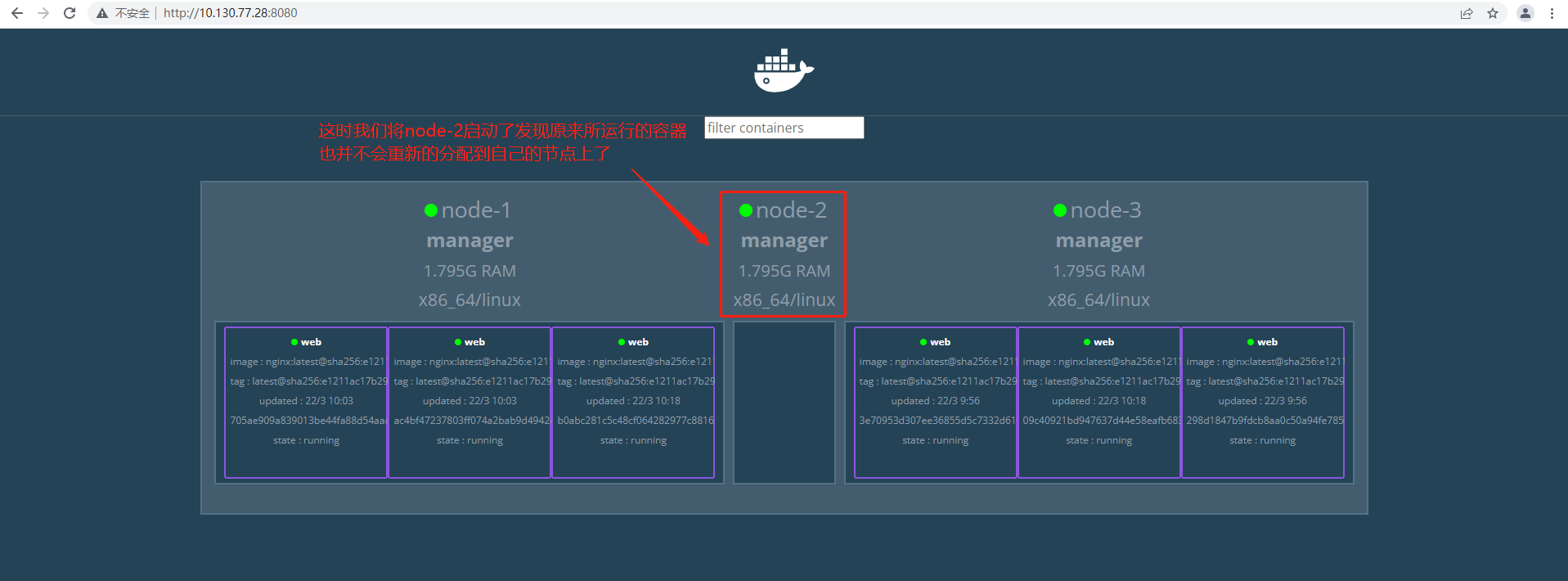

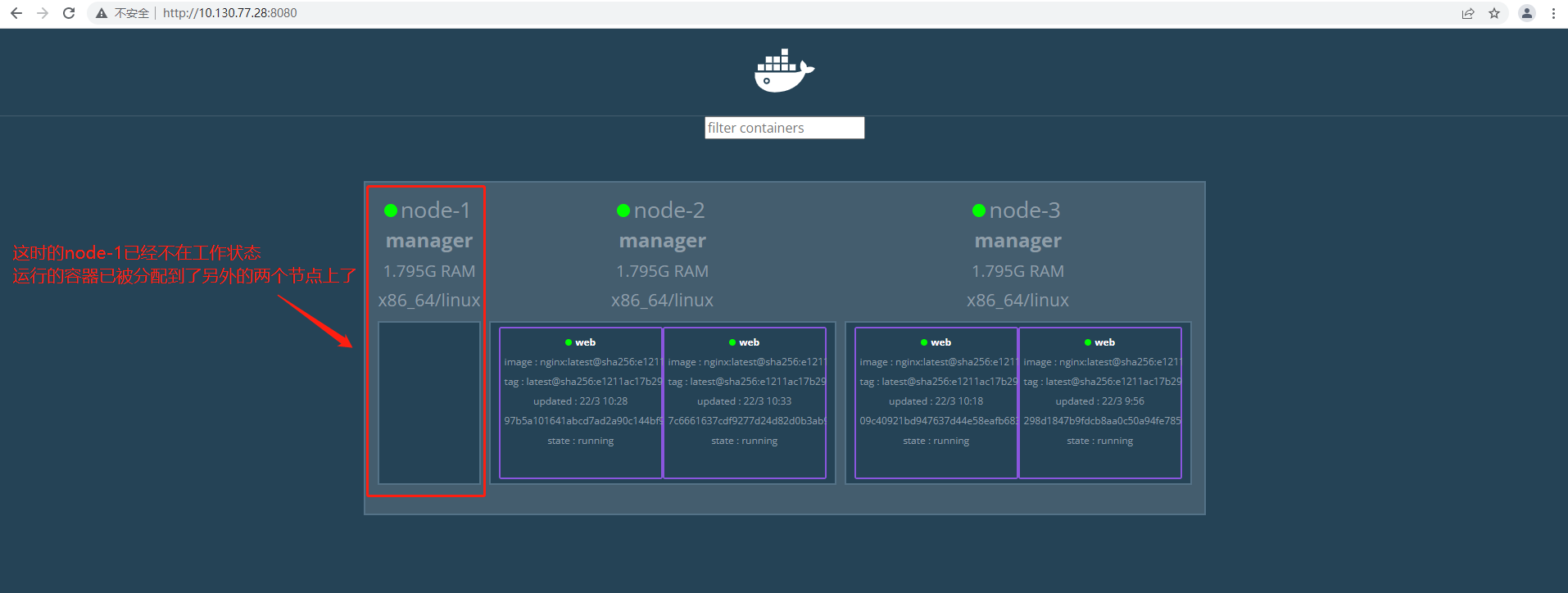

如果现在node02、node03发生宕机时,service并不会因为节点的宕机而死掉,而是自动跑到正常的节点上。

模拟node02宕机,web页面如下:

注:这里需要注意了如果我们“扩容或收缩”就可以发现原来重新启动node02会从新分配到容器,这是因为根据docker swarm自身的算法进行分配的,它会检索你的哪个节点处于健康状态如果是健康的就会重新的分配任务,如果是处于宕机就如上图所说。

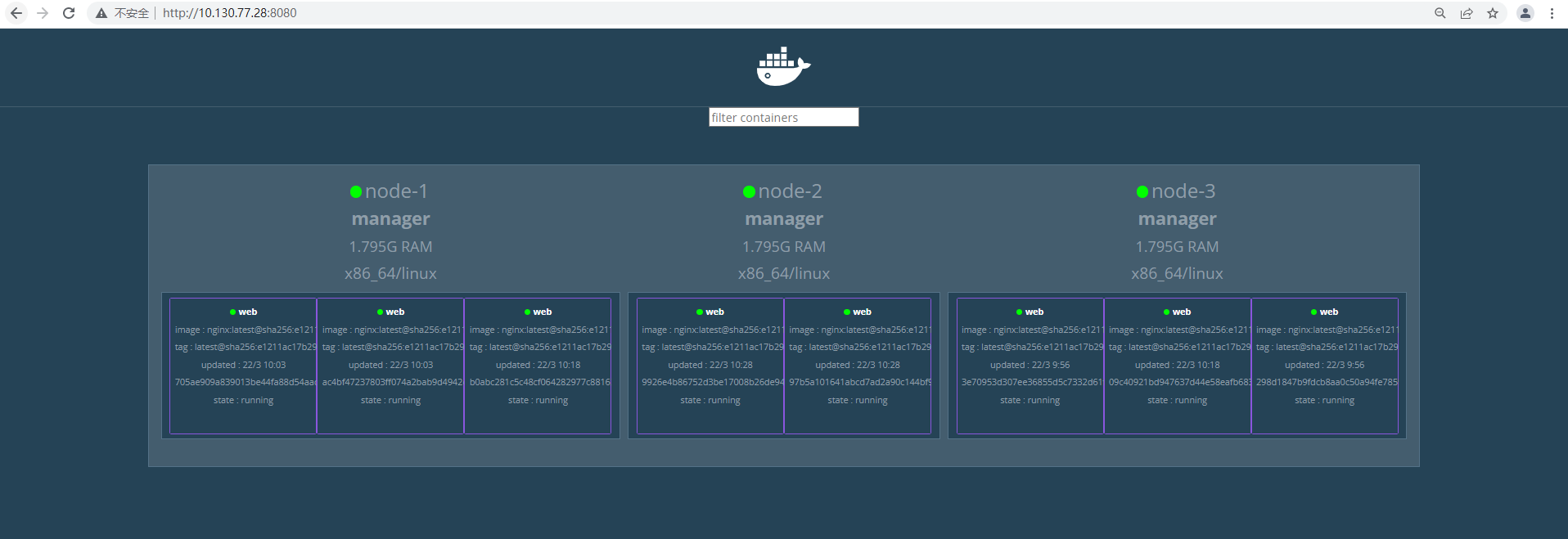

五、实现service的扩容、收缩

扩容:就是添加几台service;

收缩:就是减少几台service;

针对上述环境实现收缩、扩容;

(1)service扩容

[root@node-1 ~]# docker service scale web=8

web scaled to 8

//从原本的六台容器增加到八台

浏览器验证:

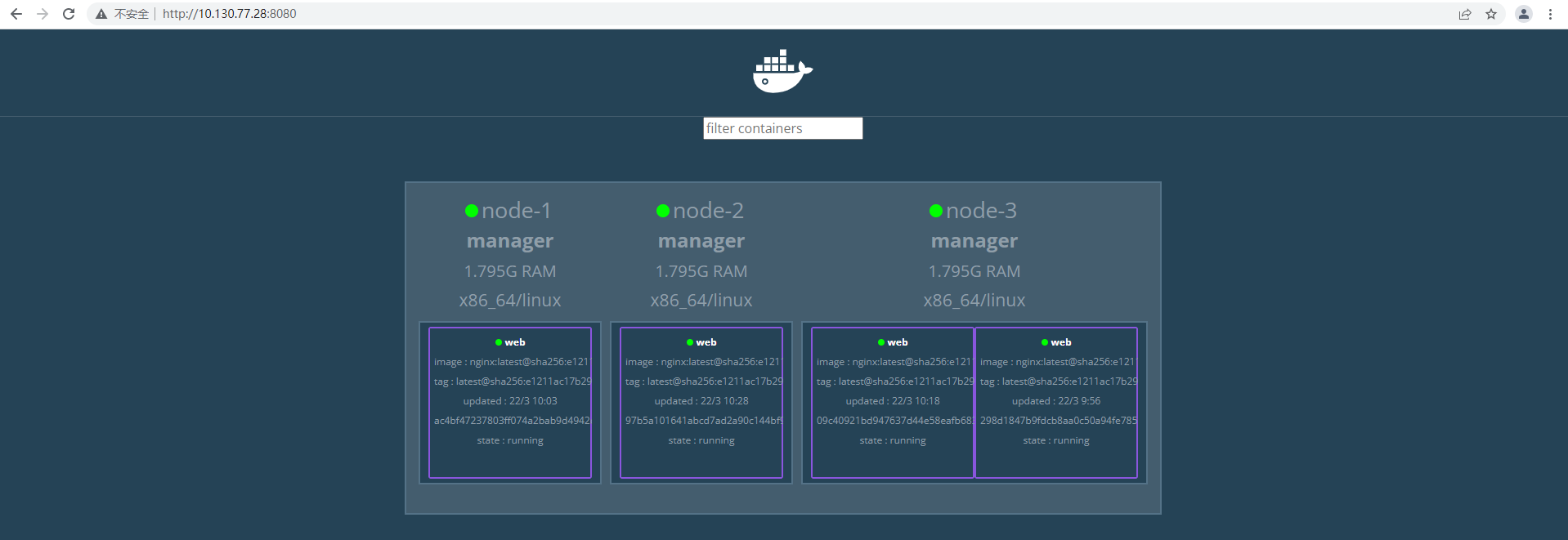

(2)service收缩

[root@node-1 ~]# docker service scale web=4

web scaled to 4

//从原本的八台减少到四台

(3)设置某个node不运行service

可以通过设置,使某台节点不运行service,如下:

[root@node-1 ~]# docker node update --availability drain node-1

//设置noder-1以后不运行容器,但已经运行的容器并不会停止

// --availability:选项后面共有三个选项可配置,如下:

active:工作;pause:暂时不工作;drain:永久性的不工作

六、搭建registry私有仓库

通过搭建registry私有仓库,可以便于让其他node下载镜像。

搭建私有仓库请参考 Docker搭建私有仓库之registry

[root@node-1 ~]# docker run -itd --name registry -p 5000:5000 -v /registry:/var/lib/registry --restart=always registry:2

[root@node-1 ~]# vim /usr/lib/systemd/system/docker.service

//更改内容为

ExecStart=/usr/bin/dockerd --insecure-registry 10.130.77.28:5000

[root@node-1 ~]# systemctl daemon-reload

[root@node-1 ~]# systemctl restart docker

[root@node-1 ~]# docker ps -a -q | xargs docker start

//由于刚才创建的容器并没有设置自动启动,所以在重启docker服务的时候,需要手动启动

[root@node-2 ~]# vim /usr/lib/systemd/system/docker.service

//更改内容为

ExecStart=/usr/bin/dockerd --insecure-registry 10.130.77.28:5000

[root@node-2 ~]# systemctl daemon-reload

[root@node-2 ~]# systemctl restart docker.service

[root@node-3 ~]# vim /usr/lib/systemd/system/docker.service

//更改内容为

ExecStart=/usr/bin/dockerd --insecure-registry 10.130.77.28:5000

[root@node-3 ~]# systemctl daemon-reload

[root@node-3 ~]# systemctl restart docker.service

//重新启动node02、node03节点的docker服务

[root@node-1 ~]# docker pull httpd

[root@node-1 ~]# docker tag httpd:latest 10.130.77.28:5000/httpd:latest

[root@node-1 ~]# docker push 10.130.77.28:5000/httpd:latest

//将httpd镜像上传到私有仓库中

[root@node-2 ~]# curl 10.130.77.28:5000/v2/_catalog //查看私有仓库中的镜像

{"repositories":["httpd"]}

[root@node-2 ~]#docker pull 10.130.77.28:5000/httpd

//下载私有库中的httpd镜像

七、service服务版本的升级与回滚

(1)准备环境

[root@node-1 ~]# mkdir version{1,2,3}

[root@node-1 ~]# cd version1/

[root@node-1 ~/version1]# echo "version1" >> index.html

[root@node-1 ~/version1]# echo -e "FROM httpd:latest\nADD index.html /usr/local/apache2/htdocs/index.html" > Dockerfile

[root@node-1 ~/version1]# docker build -t 10.130.77.28:5000/httpd:v1 .

//version1目录下模拟生成版本v1

[root@node-1 ~/version1]# cp Dockerfile ../version2/

[root@node-1 ~/version1]# cd !$

cd ../version2

[root@node01 version2]# echo "version2" >> index.html

[root@node01 version2]# docker build -t 10.130.77.28:5000/httpd:v2 .

//vesion2目录下模拟生成版本v2

[root@node-1 ~/version2]# cp Dockerfile ../version3

[root@node-1 ~/version2]# cd !$

cd ../version3

[root@node-1 ~/version3]# echo "version3" >> index.html

[root@node-1 ~/version3]# docker build -t 10.130.77.28:5000/httpd:v3 .

//vesion3目录下模拟生成版本v3

//注意在主页面做一些区分

[root@node-1 ~]# docker push 10.130.77.28:5000/httpd:v1

[root@node-1 ~]# docker push 10.130.77.28:5000/httpd:v2

[root@node-1 ~]# docker push 10.130.77.28:5000/httpd:v3

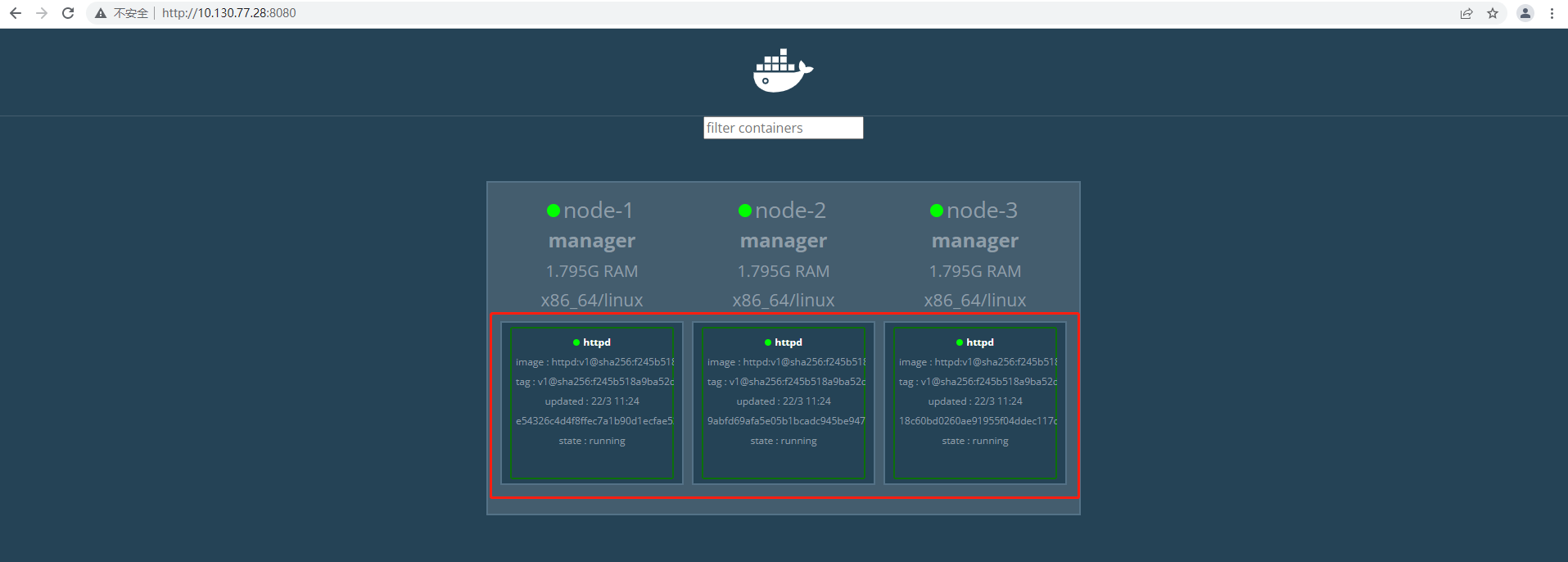

[root@node-1 ~]# docker service create --replicas 3 --name httpd 10.130.77.28:5000/httpd:v1

//基于10.130.77.28:5000/httpd:v1创建三个service副本

浏览器访问测试:

注:三个service副本是轮询的方式来服务的

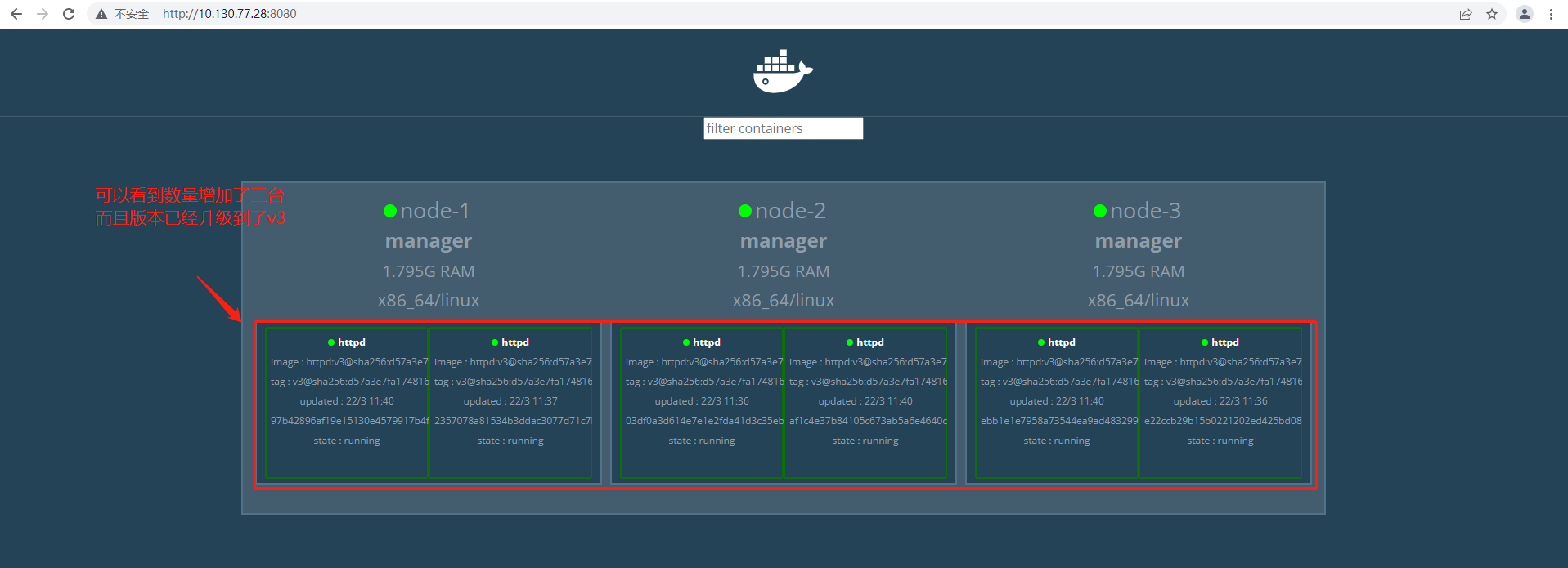

(2)版本升级

默认情况下,swarm一次只更新一个副本,并且两个副本之间并没有等待时间,可以通过以上方法进行设置。

[root@node-1 ~]# docker service update --replicas 6 --image 10.130.77.28:5000/httpd:v3 --update-parallelism 2 --update-delay 1m httpd

//--update-parallelism:设置更新的副本数量;

//--update-delay:更新的间隔时间

// --replicas 6:并在升级的过程中另外再创建3个副本

从更新的过程中可以看出效果!

浏览器确认版本更新成功:

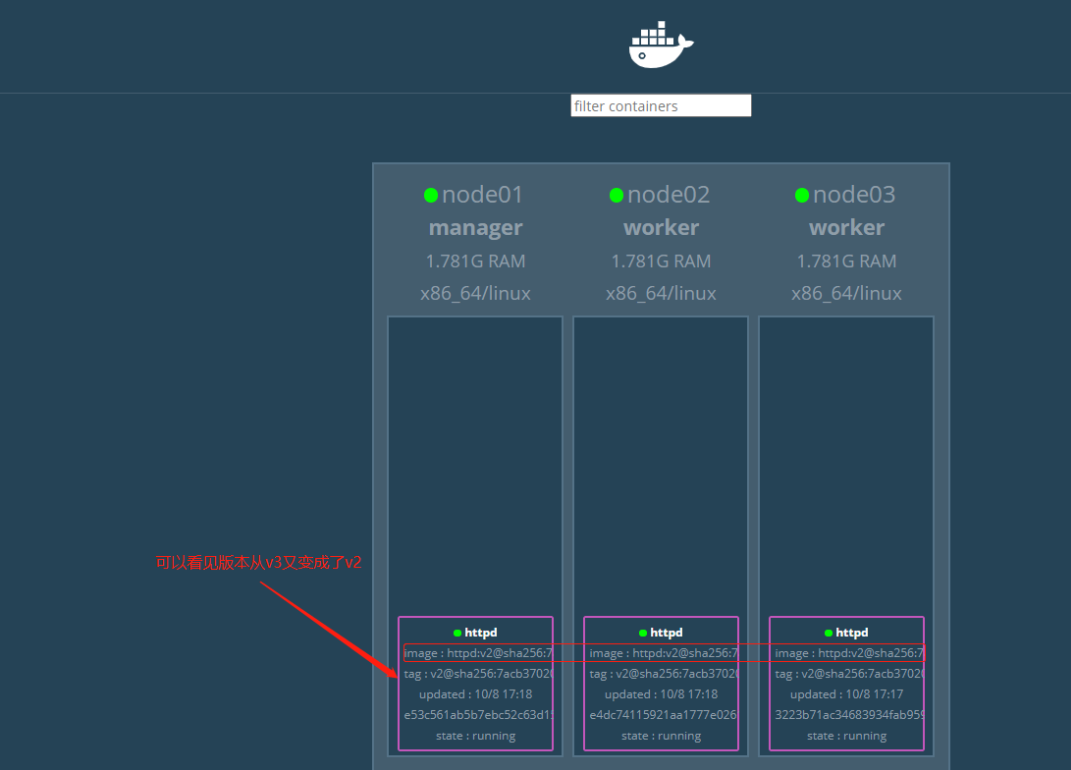

(3)版本回滚

[root@node-1 ~]# docker service rollback httpd

//回滚为上一个版本

**注意:当我们执行回滚操作的时候,默认是回滚到上一次操作的版本,并且不可以连续回滚。

**

八、Swarm中使用Volume(挂载目录,mount命令)

1) 查看volume的帮助信息

Usage: docker volume COMMAND

Manage volumes

Commands:

create Create a volume

inspect Display detailed information on one or more volumes

ls List volumes

prune Remove all unused local volumes

rm Remove one or more volumes

Run 'docker volume COMMAND --help' for more information on a command.

2) 创建一个volume

[root@node-1 ~]# docker volume create --name testvolume

testvolume

//查看创建的volume

[root@node-1 ~]# docker volume ls

DRIVER VOLUME NAME

local portainer_data

local testvolume

//查看volume详情

[root@node-1 ~]# docker volume inspect testvolume

[

{

"CreatedAt": "2022-03-23T11:56:00+08:00",

"Driver": "local",

"Labels": {},

"Mountpoint": "/var/lib/docker/volumes/testvolume/_data",

"Name": "testvolume",

"Options": {},

"Scope": "local"

}

]

3) 创建新的服务并挂载testvolume(nginx为例)

[root@node-1 ~]# docker service create --replicas 3 --mount type=volume,src=testvolume,dst=/zjz --name test_nginx nginx

3f3csgsxvod1pqplyieym24td

overall progress: 3 out of 3 tasks

1/3: running [==================================================>]

2/3: running [==================================================>]

3/3: running [==================================================>]

verify: Service converged

温馨提示:

参数src写成source也可以;dst表示容器内的路径,也可以写成target

//查看创建服务

[root@node-1 ~]# docker service ls

ID NAME MODE REPLICAS IMAGE PORTS

3f3csgsxvod1 test_nginx replicated 3/3 nginx:latest

[root@node-1 ~]# docker service ps test_nginx

ID NAME IMAGE NODE DESIRED STATE CURRENT STATE ERROR PORTS

t7pqm2l7pkl8 test_nginx.1 nginx:latest node-2 Running Running 2 minutes ago

2jwrq97ftu4p test_nginx.2 nginx:latest node-1 Running Running 2 minutes ago

2gd7ao7ezjgp test_nginx.3 nginx:latest node-3 Running Running 2 minutes ago

//查看有没有挂载成功(登录各个节点的容器看看有没有指定的目录并创建文件测试)

//容器中操作

[root@node-1 ~]# docker exec -it a0335ae6570b /bin/bash

root@a0335ae6570b:/# cd /zjz/

root@a0335ae6570b:/zjz# ls

root@a0335ae6570b:/zjz# echo "test" > docker.txt

root@a0335ae6570b:/zjz# ls

docker.txt

执行docker volume inspect testvolume 可以看到本地的路径(上面已经执行过了)

本地路径:/var/lib/docker/volumes/testvolume/_data

[root@node-1 ~]# cd /var/lib/docker/volumes/testvolume/_data

[root@node-1 /var/lib/docker/volumes/testvolume/_data]# ls

docker.txt

[root@node-1 /var/lib/docker/volumes/testvolume/_data]# cat docker.txt

test

还可以将node节点机上的volume数据目录做成软链接

[root@node-1 /var/lib/docker/volumes/testvolume/_data]# ln -s /var/lib/docker/volumes/testvolume/_data /zjz

[root@node-1 /var/lib/docker/volumes/testvolume/_data]# cd /zjz/

[root@node-1 /zjz]# ls

docker.txt

[root@node-1 /zjz]# echo "123" > 1.txt

[root@node-1 /zjz]# ll

总用量 8

-rw-r--r--. 1 root root 4 3月 23 16:41 1.txt

-rw-r--r--. 1 root root 5 3月 23 16:37 docker.txt

//容器中查看

root@a0335ae6570b:/zjz# ls

1.txt docker.txt

root@a0335ae6570b:/zjz# cat 1.txt

123

root@a0335ae6570b:/zjz# cat docker.txt

test

//还有一种挂载方式简单说一下吧,上面的会了下面的肯定简单

命令格式:

docker service create --mount type=bind,target=/container_data/,source=/host_data/

其中,参数target表示容器里面的路径,source表示本地硬盘路径

//示例创建并挂载并使用网络

[root@node-1 ~]# docker service create --replicas 1 --mount type=bind,target=/usr/share/nginx/html/,source=/opt/web/ --network nginx_net --name zjz_nginx -p 8880:80 nginx

九、Docker Swarm 容器网络

在Docker版本1.12之后swarm模式原生支持覆盖网络(overlay networks),可以先创建一个覆盖网络,然后启动容器的时候启用这个覆盖网络,

这样只要是这个覆盖网络内的容器,不管在不在同一个宿主机上都能相互通信,即跨主机通信!不同覆盖网络内的容器组之间是相互隔离的(相互ping不通)。

swarm模式的覆盖网络包括以下功能:

1)可以附加多个服务到同一个网络。

2)默认情况下,service discovery为每个swarm服务分配一个虚拟IP地址(vip)和DNS名称,使得在同一个网络中容器之间可以使用服务名称为互相连接。

3)可以配置使用DNS轮循而不使用VIP

4)为了可以使用swarm的覆盖网络,在启用swarm模式之间你需要在swarm节点之间开放以下端口:

5)TCP/UDP端口7946 – 用于容器网络发现

6)UDP端口4789 – 用于容器覆盖网络

1.在Swarm集群中创建overlay网络

[root@node-1 ~]# docker network create --driver overlay --opt encrypted --subnet 192.168.10.0/24 ngx_net

参数解释:

–opt encrypted 默认情况下swarm中的节点通信是加密的。在不同节点的容器之间,可选的–opt encrypted参数能在它们的vxlan流量启用附加的加密层。

–subnet 命令行参数指定overlay网络使用的子网网段。当不指定一个子网时,swarm管理器自动选择一个子网并分配给网络。

[root@node-1 ~]# docker network ls

NETWORK ID NAME DRIVER SCOPE

24efcad099ce bridge bridge local

258c5122700b docker_gwbridge bridge local

14b7f3336b61 host host local

jv78xjrvzqyn ingress overlay swarm

h1ick1mwwvg4 ngx_net overlay swarm

d9d90ae2e20d none null local

由上可知,Swarm当中拥有2套覆盖网络。其中"ngx_net"网络正是我们在部署容器时所创建的成果。而"ingress"覆盖网络则为默认提供。

Swarm 管理节点会利用 ingress 负载均衡以将服务公布至集群之外。

在将服务连接到这个创建的网络之前,网络覆盖到manager节点。上面输出的SCOPE为 swarm 表示将服务部署到Swarm时可以使用此网络。

在将服务连接到这个网络后,Swarm只将该网络扩展到特定的worker节点,这个worker节点被swarm调度器分配了运行服务的任务。

在那些没有运行该服务任务的worker节点上,网络并不扩展到该节点。

2.将服务连接到overlay网络

[root@node-1 ~]# docker service create --replicas 5 --network ngx_net --name my-test -p 80:80 nginx

上面名为"my-test"的服务启动了3个task,用于运行每个任务的容器都可以彼此通过overlay网络进行通信。Swarm集群将网络扩展到所有任务处于Running状态的节点上。

[root@node-1 ~]# docker service ls

ID NAME MODE REPLICAS IMAGE PORTS

xb6kq5en5bft my-test replicated 5/5 nginx:latest *:80->80/tcp

在manager-node节点上,通过下面的命令查看哪些节点有处于running状态的任务:

[root@node-1 ~]# docker service ps my-test

ID NAME IMAGE NODE DESIRED STATE CURRENT STATE ERROR PORTS

i6psv41803r9 my-test.1 nginx:latest node-1 Running Running about a minute ago

rfdsupa3rjpi my-test.2 nginx:latest node-3 Running Running about a minute ago

vn1kl8jp7byk my-test.3 nginx:latest node-1 Running Running about a minute ago

2rgmy6kcx0hf my-test.4 nginx:latest node-3 Running Running about a minute ago

y4t44e5kz02s my-test.5 nginx:latest node-2 Running Running about a minute ago

可见三个节点都有处于running状态的任务,所以my-network网络扩展到三个节点上。

可以查询某个节点上关于my-network的详细信息:

[root@node-1 ~]# docker network inspect ngx_net

[

{

"Name": "ngx_net",

"Id": "h1ick1mwwvg44biaol6x4hsgw",

"Created": "2022-03-23T17:18:56.998188035+08:00",

"Scope": "swarm",

"Driver": "overlay",

"EnableIPv6": false,

"IPAM": {

"Driver": "default",

"Options": null,

"Config": [

{

"Subnet": "192.168.10.0/24",

"Gateway": "192.168.10.1"

}

]

},

"Internal": false,

"Attachable": false,

"Ingress": false,

"ConfigFrom": {

"Network": ""

},

"ConfigOnly": false,

"Containers": {

"49942ae51f90ca2edc4a3165f550228e3cbab850dc6075739716d7fee6a2946f": {

"Name": "my-test.3.vn1kl8jp7bykryhfj3ds28hiv",

"EndpointID": "2dafa415f40c424dd16051472214d204f166c38a58713bbb19aa7c5e1ea3426d",

"MacAddress": "02:42:c0:a8:0a:05",

"IPv4Address": "192.168.10.5/24",

"IPv6Address": ""

},

"7918e412f172ff803737ad17503be88fa3cc66e5f329580dbbd1027d902fec02": {

"Name": "my-test.1.i6psv41803r9ikix5ea3bo40t",

"EndpointID": "b5ad8f2fa88a28eae5d5fd7bac321b9fa0c45c6ef464b0f13bce2df413651b2c",

"MacAddress": "02:42:c0:a8:0a:03",

"IPv4Address": "192.168.10.3/24",

"IPv6Address": ""

},

"lb-ngx_net": {

"Name": "ngx_net-endpoint",

"EndpointID": "e9482eb149f80fcb469cb78cef47f480bb3bb321b32570f2dde424a6a230cd02",

"MacAddress": "02:42:c0:a8:0a:08",

"IPv4Address": "192.168.10.8/24",

"IPv6Address": ""

}

},

"Options": {

"com.docker.network.driver.overlay.vxlanid_list": "4098",

"encrypted": ""

},

"Labels": {},

"Peers": [

{

"Name": "be7237b59b98",

"IP": "10.130.77.28"

},

{

"Name": "56c6882df044",

"IP": "10.130.77.31"

},

{

"Name": "6688cbe69f33",

"IP": "10.130.77.36"

}

]

}

]

从上面的信息可以看出在manager-node节点上,名为my-test的服务有一个名为my-test.5.btorxekfix4hcqh4v83dr0tzw和

my-test.4.cyu73jd8psupfhken23vvmpud的task连接到名为ngx_net的网络上(另外两个节点node1和node2同样可以用上面命令查看)

可以通过查询服务来获得服务的虚拟IP地址,如下:

[root@node-1 ~]# docker service inspect --format='{{json .Endpoint.VirtualIPs}}' my-test

[{"NetworkID":"jv78xjrvzqynwozvr7fpg2u6j","Addr":"10.0.0.3/24"},{"NetworkID":"h1ick1mwwvg44biaol6x4hsgw","Addr":"192.168.10.2/24"}]\

由上结果可知,192.168.10.2其实就是swarm集群内部的vip。

加入ngx_net网络的容器彼此之间可以通过IP地址通信,也可以通过名称通信。

评论区