1、前置要求

服务器要求:

- 最小配置: 2 核 CPU 、 2G 内存、 20G 硬盘

- 服务器最好可以访问外网,会有从网上拉取镜像需求,如果服务器不能上网,需要提前下载对应镜像并导入

- 服务器ip选择固定ip

2、开始部署

2.1 操作系统初始化配置【所有节点】

关闭防火墙

systemctl stop firewalld

systemctl disable firewalld

关闭selinux

sed -i 's/enforcing/disabled/' /etc/selinux/config # 永久

setenforce 0 # 临时

关闭swap

swapoff -a # 临时

sed -ri 's/.*swap.*/#&/' /etc/fstab # 永久

根据规划设置主机名

hostnamectl set-hostname <hostname>

在master添加hosts

cat >> /etc/hosts << EOF

10.130.77.37 k8s-master

10.130.77.38 k8s-node1

10.130.77.40 k8s-node2

EOF

将桥接的IPv4流量传递到iptables的链

cat > /etc/sysctl.d/k8s.conf << EOF

net.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

net.ipv4.ip_forward = 1

EOF

sysctl --system # 生效

时间同步

yum install ntpdate -y

ntpdate time.windows.com

2.2 安装Docker/kubeadm/kubelet【所有节点】

这里使用Docker作为容器引擎,也可以换成别的,例如containerd

2.2.1 安装Docker

wget https://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo -O /etc/yum.repos.d/docker-ce.repo

yum -y install docker-ce

systemctl enable docker && systemctl start docker

配置镜像下载加速器:

cat > /etc/docker/daemon.json << EOF

{

"registry-mirrors": ["https://b9pmyelo.mirror.aliyuncs.com"],

"exec-opts": ["native.cgroupdriver=systemd"]

}

EOF

systemctl restart docker

docker info

2.2.2 添加阿里云 YUM 软件源

cat > /etc/yum.repos.d/kubernetes.repo << EOF

[kubernetes]

name=Kubernetes

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64

enabled=1

gpgcheck=0

repo_gpgcheck=0

gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

EOF

2.2.3 安装kubeadm,kubelet和kubectl

由于版本更新频繁,这里指定版本号部署:

yum install -y kubelet-1.23.0 kubeadm-1.23.0 kubectl-1.23.0

systemctl enable kubelet

2.2.4部署Kubernetes Master

在10.130.77.37(Master)执行。

kubeadm init \

--apiserver-advertise-address=10.130.77.37 \

--image-repository registry.aliyuncs.com/google_containers \

--kubernetes-version v1.23.0 \

--service-cidr=10.1.0.0/16 \

--pod-network-cidr=10.244.0.0/16 \

--ignore-preflight-errors=all

- –apiserver-advertise-address 集群通告地址

- –image-repository 由于默认拉取镜像地址k8s.gcr.io国内无法访问,这里指定阿里云镜像仓库地址

- –kubernetes-version K8s版本,与上面安装的一致

- –service-cidr 集群内部虚拟网络,Pod统一访问入口

- –pod-network-cidr Pod网络,与下面部署的CNI网络组件yaml中保持一致

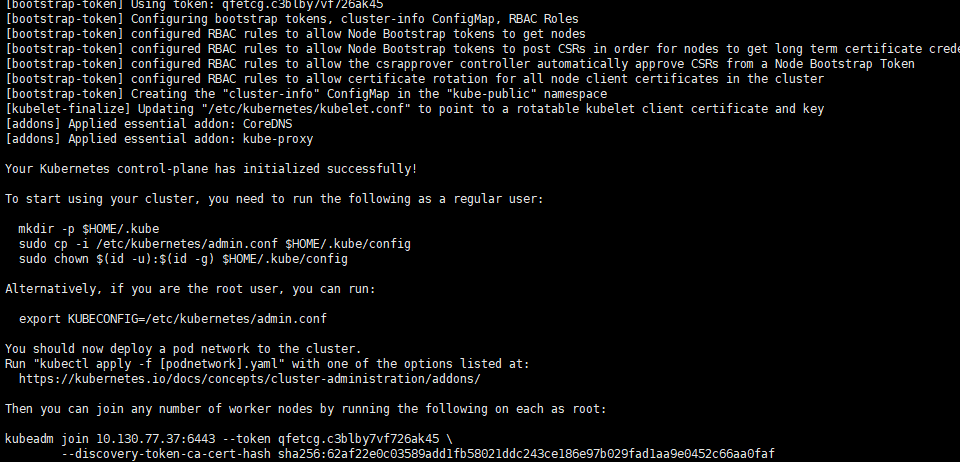

初始化完成后,最后会输出一个 join 命令,先记住,下面用。

如出现异常问题,查看/var/log/messages日志看是否是因为kubelet的cgroup和docker的不一致所导致的(“kubelet cgroup驱动为systemd,而docker的为cgroupfs”),如果是需要修改修改docker的cgroup为systemd

“exec-opts”: [“native.cgroupdriver=systemd”]

拷贝kubectl使用的连接k8s认证文件到默认路径:

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config

查看工作节点:

kubectl get nodes

NAME STATUS ROLES AGE VERSION

k8s-master NotReady control-plane,master 13m v1.23.0

注:由于网络插件还没有部署,还没有准备就绪 NotReady,先继续

2.2.5 加入Kubernetes Node

在10.130.77.38/40(Node)执行。

向集群添加新节点,执行在kubeadm init输出的kubeadm join命令:

kubeadm join 10.130.77.37:6443 --token qfetcg.c3blby7vf726ak45 \

--discovery-token-ca-cert-hash sha256:62af22e0c03589add1fb58021ddc243ce186e97b029fad1aa9e0452c66aa0faf

默认 token 有效期为 24 小时,当过期之后,该 token 就不可用了。这时就需要重新创建 token ,可以直接使用命令快捷生成:

kubeadm token create --print-join-command

2.2.6 部署容器网络

选项1、这里使用calico容器网络模式

wget https://docs.projectcalico.org/manifests/calico.yaml

下载完后还需要修改里面定义Pod网络(CALICO_IPV4POOL_CIDR),与前面kubeadm init的 --pod-network-cidr指定的一样。

修改完后文件后,部署:

kubectl apply -f calico.yaml

kubectl get pods -n kube-system

等Calico Pod都Running,节点也会准备就绪。

选项2、也可以使用Fannel网络模式

可以查看官网的要求:

https://kubernetes.io/docs/setup/production-environment/tools/kubeadm/create-cluster-kubeadm/

安装命令:

kubectl apply -f https://raw.githubusercontent.com/coreos/flannel/master/Documentation/kube-flannel.yml

如下输出:

podsecuritypolicy.policy/psp.flannel.unprivileged created

clusterrole.rbac.authorization.k8s.io/flannel created

clusterrolebinding.rbac.authorization.k8s.io/flannel created

serviceaccount/flannel created

configmap/kube-flannel-cfg created

daemonset.apps/kube-flannel-ds created

确保您的防火墙规则允许UDP端口8285和8472与所有参加overlay网络的主机通信。

查看集群节点是否正常

kubectl get nodes

评论区